2023-08-02

目次

-

1.

はじめに

-

2.

参考書籍

-

1〜4:データの読み込み・結合

-

7:統計量をみてみよう

-

8:月別でデータを集計してみよう

-

9〜10:月別、商品別でデータを集計して可視化してみる

-

3.

おわりに

はじめに

皆さん、こんにちは!松本祐輝です!本記事では、「Python 実践データ分析 100本ノック」をコードを書かずに、ChatGPTのCode Interpreterで挑戦してみたお話です!

つまり、どういうことかといいますとノックを受けるのは自分ではなくAIです笑

参考書籍

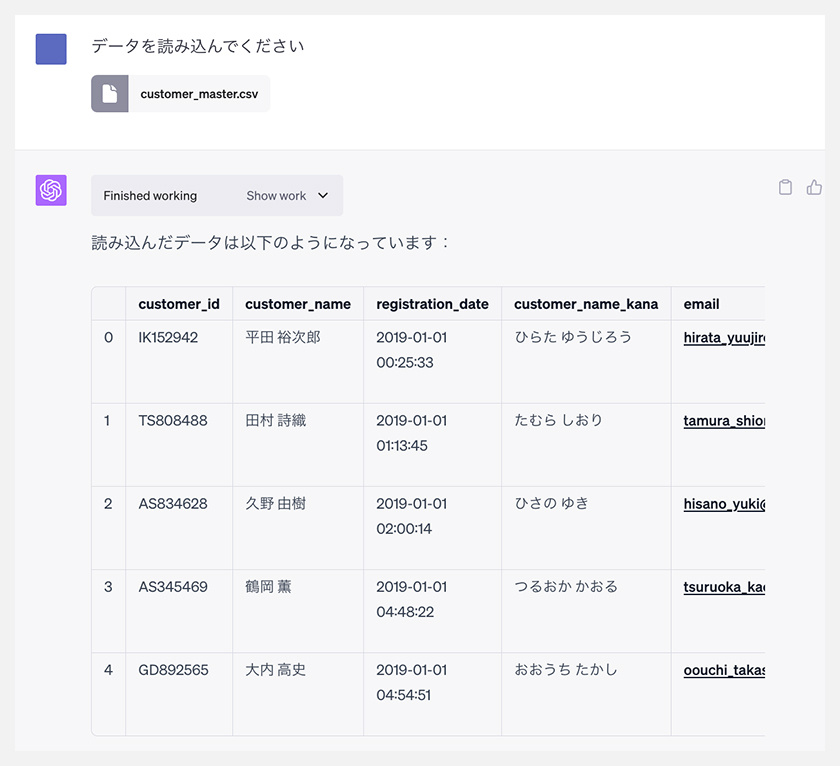

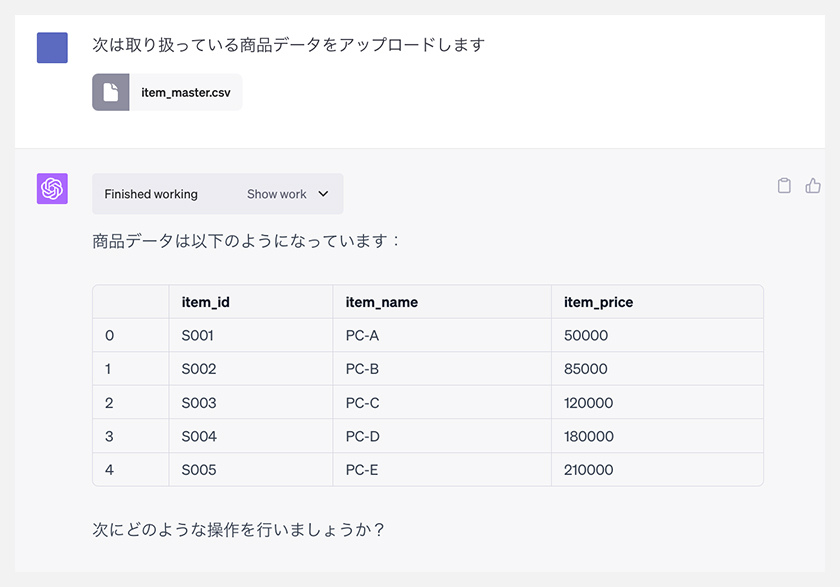

1〜4:データの読み込み・結合

まずは、データをChatGPTで読み込みます。

この後、もう4つデータをアップロードして結合するみたいですが、いつも通り、読み込み・結合をぱぱっとやってもらいましょう笑

この後、もう4つデータをアップロードして結合するみたいですが、いつも通り、読み込み・結合をぱぱっとやってもらいましょう笑

5〜6:列を作る・データ検算をしよう

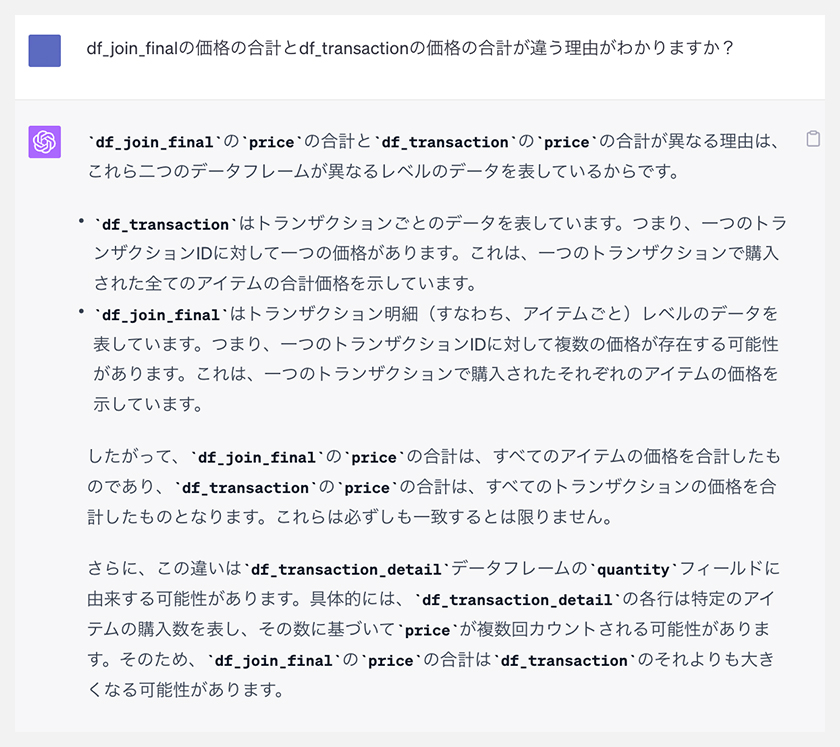

価格の列が結合した影響で落ちてしまうみたいなのですが、ChatGPTが結合したデータフレームには、価格の列があるので検算してデータが正しいかみてみましょう!

おっと、合計価格にかなりの差がありますね!

なぜそうなっているのか、ChatGPTに聞いてみましょう!

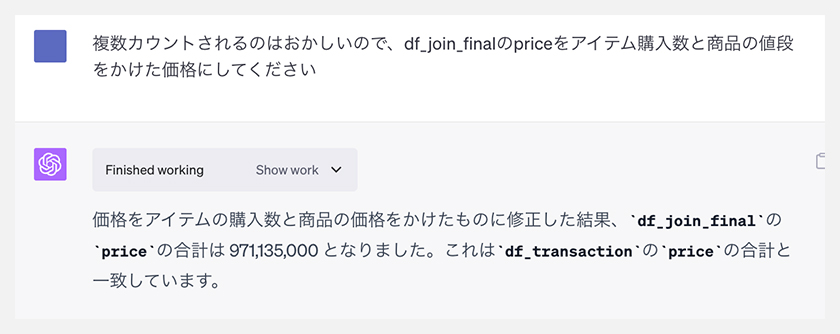

なるほど、IDに対して価格が紐づいていると解釈して、重複が発生したせいで、合計金額に差異が出たんですね。

この辺りは、ChatGPTに頼りきりではいけないという気づきになりますね。

しっかりデータセットを理解した上でAIを活用しなければ、正しい分析ができなくなってしまうので要注意ですね。それでは直してもらいましょう!

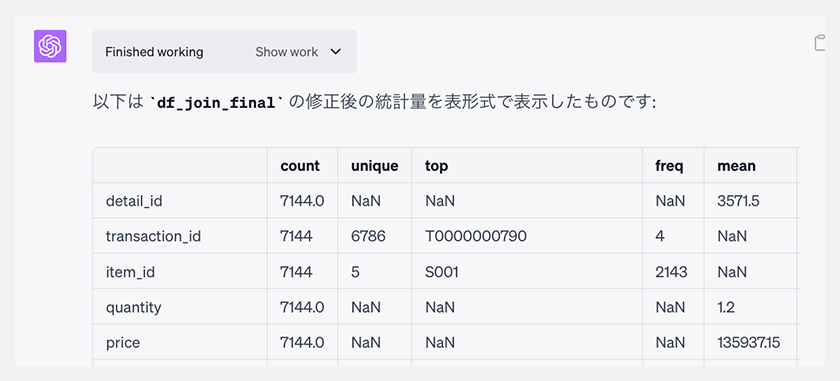

7:統計量をみてみよう

統計量を出してもらいます。

8:月別でデータを集計してみよう

集計してもらいます。

毎月のはじめにピークがあるみたいなので、詳しくみてみたいですが今回は本にならって進めているのでながしますね…

9〜10:月別、商品別でデータを集計して可視化してみる

ついに最後の10本まで辿り着きました。

可視化してもらいましょう!

おわりに

10本ノックにかかった時間はなんと約10分!!本当にすごいですね!

ただ、今回結合の時に発生したように、ChatGPTの解釈が間違っている場合もあるので、まだAIはあくまで補助的な立ち位置であることには十分気をつけなければいけませんね!

これからは初手ChatGPTで探索分析などを実行して全体像の把握時間の短縮、その後dataikuなどを使用して本格データ分析を進めていくなどのやり方が、作業効率を上げていくかもしれませんね。